WebTech Rodos: Η αυξανόμενη όρεξη της Anthropic για δεδομένα χρηστών οδήγησε σε μια αλλαγή στην πολιτική απορρήτου, η οποία θα παρέχει στην AI της εταιρείας μια σταθερή ροή πληροφοριών.

Στο παρελθόν, η Anthropic δεν εκπαίδευε τα μοντέλα τεχνητής νοημοσύνης Claude με βάση τις συνομιλίες των χρηστών και δεσμευόταν να διαγράφει αυτόματα τα δεδομένα μετά από 30 ημέρες, σύμφωνα με το TechCrunch. Τώρα, σας ζητά να «βοηθήσετε στη βελτίωση του Claude», επιτρέποντας στις συνομιλίες και τις συνεδρίες προγραμματισμού σας να εκπαιδεύσουν την τεχνητή νοημοσύνη της Anthropic.

Θα διατηρεί επίσης τα δεδομένα για πέντε χρόνια, ώστε να παραμείνει «συνεπής» καθ’ όλη τη διάρκεια του μακροχρόνιου κύκλου ανάπτυξης της τεχνητής νοημοσύνης. «Τα μοντέλα που κυκλοφόρησαν σήμερα άρχισαν να αναπτύσσονται πριν από 18 έως 24 μήνες», αναφέρει η Anthropic.

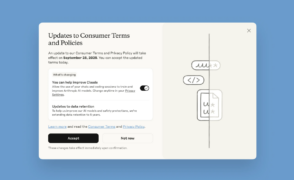

Την επόμενη φορά που θα συνδεθείτε, θα δείτε ένα αναδυόμενο μενού που θα σας ζητά να αποδεχτείτε μια ενημέρωση των όρων και των πολιτικών της εταιρείας. Η επιλογή «μπορείτε να βοηθήσετε στη βελτίωση του Claude» θα είναι ενεργοποιημένη από προεπιλογή. Δεν υπάρχει επιλογή ενεργοποίησης/απενεργοποίησης σε ότι αφορά τη διατήρηση δεδομένων. Η Anthropic σας ζητά να αποδεχτείτε τους όρους έως τις 28 Σεπτεμβρίου.

Existing users will opt in or out of data retention through this pop-up

(Credit: Anthropic)

Εάν αποδεχτείτε τους όρους και αλλάξετε γνώμη, μπορείτε να ανακαλέσετε την πρόσβαση μέσω των Settings > Privacy > Help improve Claude.

(Credit: PCMag/Anthropic)

Οι αλλαγές θα ισχύουν για νέες ή παλαιότερες συνομιλίες και συνεδρίες coding στα προγράμματα Claude Free, Pro και Max για κανονικές συνομιλίες και εργαλεία coding όπως το Claude Code. Δεν θα ισχύουν για το Claude for Work, το Claude Gov, το Claude for Education ή τη χρήση API, συμπεριλαμβανομένων τρίτων μερών όπως το Amazon Bedrock και το Vertex AI του Google Cloud.

Μπορείτε επίσης να επιλέξετε να κάνετε opt in, αλλά να διατηρήσετε ορισμένες συνομιλίες ιδιωτικές διαγράφοντάς τες, κάτι που θα αποτρέψει τη χρήση τους για «μελλοντική εκπαίδευση μοντέλων», σύμφωνα με την Anthropic.

Όπως ήταν αναμενόμενο, η Anthropic παρουσιάζει την κίνηση αυτή ως επωφελή για τους χρήστες. Η εταιρεία αναφέρει ότι η ύπαρξη περισσότερων πληροφοριών θα ενισχύσει την ασφάλεια των μοντέλων και θα τα καταστήσει πιο ικανά να επισημαίνουν με ακρίβεια επιβλαβείς συνομιλίες. Θα συμβάλει επίσης στη δημιουργία καλύτερων μοντέλων στο μέλλον, με ισχυρότερες δεξιότητες «προγραμματισμού, ανάλυσης και συλλογιστικής».

«Όλα τα μεγάλα γλωσσικά μοντέλα, όπως το Claude, εκπαιδεύονται χρησιμοποιώντας μεγάλες ποσότητες δεδομένων», αναφέρει η Anthropic. «Τα δεδομένα από αλληλεπιδράσεις στον πραγματικό κόσμο παρέχουν πολύτιμες πληροφορίες σχετικά με τις απαντήσεις που είναι πιο χρήσιμες και ακριβείς για τους χρήστες».

Από σήμερα, οι υπάρχοντες χρήστες θα βλέπουν ένα αναδυόμενο παράθυρο που θα τους ρωτά αν επιθυμούν να συμμετάσχουν. Προς τιμήν της Anthropic, το μήνυμα είναι αρκετά σαφές, αναφέροντας ότι η εταιρεία θα χρησιμοποιήσει τις συνομιλίες και τις συνεδρίες προγραμματισμού σας για να βελτιώσει τα μοντέλα της. Μπορείτε επίσης να κάνετε την επιλογή σας στο μενού «Ρυθμίσεις».

«Για την προστασία της ιδιωτικότητας των χρηστών, χρησιμοποιούμε ένα συνδυασμό εργαλείων και αυτοματοποιημένων διαδικασιών για να φιλτράρουμε ή να αποκρύψουμε ευαίσθητα δεδομένα», αναφέρει η Anthropic. «Δεν πωλούμε τα δεδομένα των χρηστών σε τρίτους».

πηγή: pcmag.com